Nvidia 升级低成本 Jetson AI 计算机--只需一半的价格就能获得更强大的性能

售价 249 美元的 Jetson Orin Nano Super 将近乎两倍的人工智能处理能力集成到了一个手掌大小的设备中,使业余爱好者更容易获得。

对于人工智能开发者和爱好者来说,这是一个好消息:英伟达(Nvidia)刚刚降低了制造人工智能机器人、无人机、智能相机和其他需要大脑的小工具的成本。该公司本周二发布的新款 Jetson Orin Nano Super 处理能力比上一代产品更强,但售价只有上一代产品的一半,仅为 249 美元。

这款手掌大小的电脑性能提升了 70%,人工智能任务的运算速度达到每秒 67 万亿次。与早期型号相比,这是一个重大飞跃,尤其是在为聊天机器人、计算机视觉和机器人应用等提供动力方面。

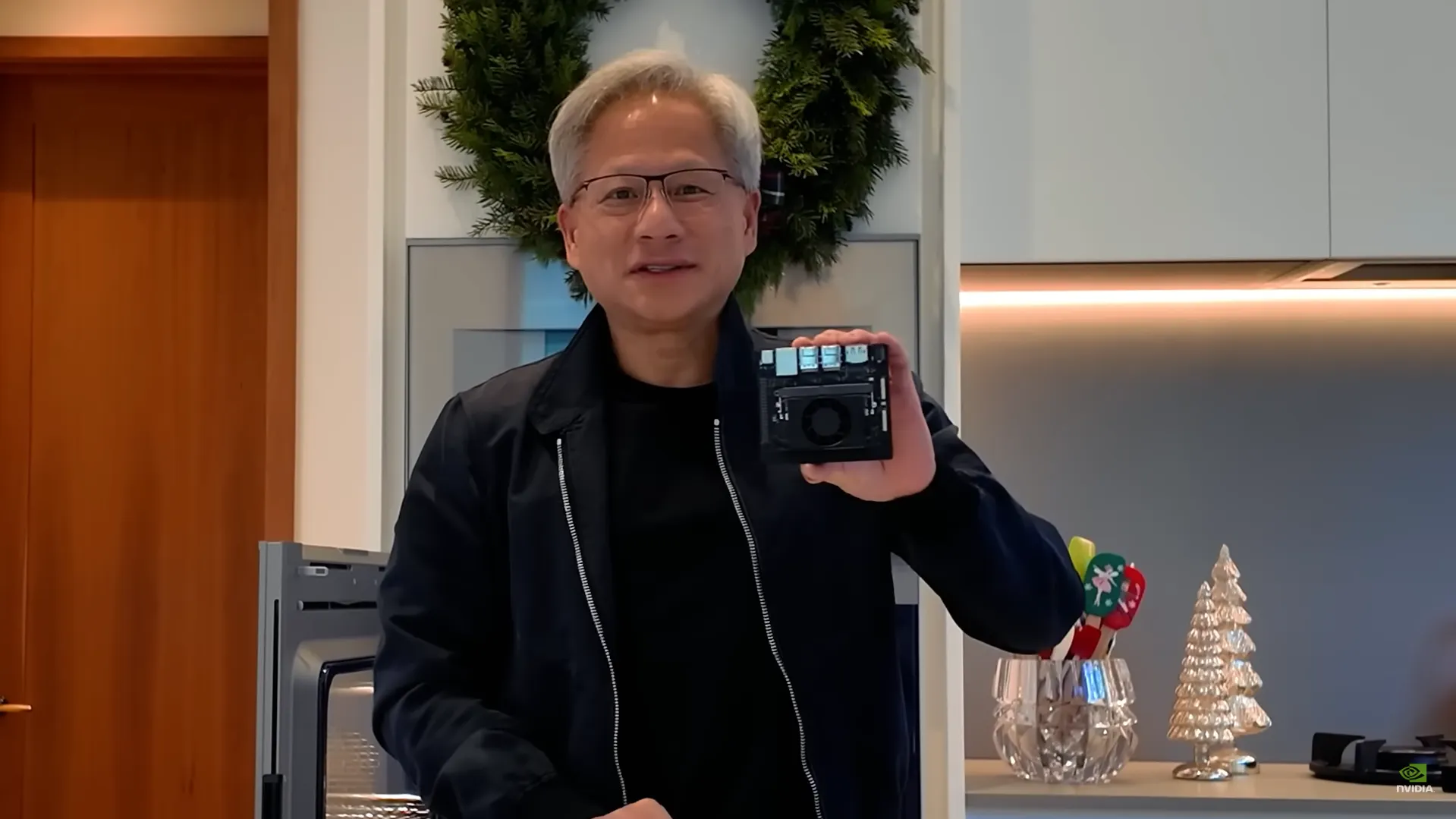

"这是全新的 Jetson Nano Super。每秒近 70 万亿次运算,25 瓦,249 美元,"Nvidia 首席执行官黄仁勋(Jensen Huang)在自家厨房播放的官方视频中说道。"它可以运行 HGX 的所有功能,甚至可以运行 LLM。

内存带宽也有重大升级,增加到每秒 102 千兆字节,比上一代 Jetson 快 50%。这一改进意味着该设备可以处理更复杂的人工智能模型,并同时处理多达四个摄像头的数据。

该设备配备了 Nvidia 的 Ampere 架构 GPU 和 6 核 ARM 处理器,可同时运行多个 AI 应用程序。这就为开发人员提供了开发更多能力的可能性,比如为机器人建立小型模型,使其能够在低处理能力的情况下进行环境映射、物体识别和语音指令等工作。

现有的 Jetson Orin Nano 用户也不会被冷落。Nvidia 正在发布软件更新,以提高其传统 AI 处理器的效率。

Nvidia 新款 Jetson Orin Nano Super 背后的数字说明了一个有趣的故事。与 RTX 2060 的 1,920 个内核、RTX 3060 的 3,584 个内核或 RTX 4060 的 3,072 个内核相比,它只有 1,024 个 CUDA 内核,看起来并不起眼。但原始核心数量并不能说明一切。

RTX 系列等游戏 GPU 的耗电量在 115 瓦到 170 瓦之间,而 Jetson 的耗电量仅为 7 瓦到 25 瓦。这大约是最高效的 RTX 4060 功耗的七分之一。

内存带宽数据也显示了类似的情况。与 RTX 显卡 300 多 GB/s 的带宽相比,Jetson 102 GB/s 的带宽可能显得不尽如人意,但它是专门针对边缘人工智能工作负载而优化的,在边缘人工智能工作负载中,高效的数据处理比原始吞吐量更重要。

也就是说,真正的神奇之处在于人工智能性能。该设备可为人工智能任务提供 67 TOPS(每秒万亿次运算)的性能--这个数字很难与 RTX 显卡的 TFLOPS 直接比较,因为它们测量的是不同类型的运算。

但在实际应用中,Jetson 可以同时处理运行本地 AI 聊天机器人、处理多个摄像头馈送和控制机器人等任务,其功耗预算几乎无法满足游戏 GPU 冷却风扇的运行需要,基本上可以与 RTX 2060 并驾齐驱,但成本和功耗却只有 RTX 2060 的几分之一。

它的 8GB 共享内存看似较低,但这意味着在运行 Flux 或 Stable Diffusion 等本地 AI 模型时,它比普通 RTX 2060 更有能力,因为这些 GPU 可能会出现 "内存不足 "的错误,或者将部分工作卸载到普通 RAM,从而缩短推理时间--基本上就是 AI 的思考过程。

Jetson Orin Nano Super 还支持各种小型和大型语言模型,包括多达 80 亿个参数的模型,如 Llama 3.1 模型。在使用这些模型的量化版本时,它能以大约每秒 18-20 个的速度生成词块。虽然有点慢,但对于某些本地应用来说还是足够了。不过,与上一代 Jetson AI 硬件型号相比,它还是有所进步的。

鉴于其价格和特性,Jetson Orin Nano Super 主要是为原型设计和小规模应用而设计的。对于需要大量计算资源的高级用户、企业或应用来说,该设备的功能与价格更高、需要更多电力的高端系统相比可能会有局限性。

编辑:安德鲁-海沃德

Related News

- 以太坊和 Solana NFT 骗子在 2200 万美元的拉扯计划中被起诉

- 比特币和 XRP 暴涨后本周下跌 23

- 比特币合众国?这些国家正在考虑储备 BTC

- 人工智能不会告诉你如何制造炸弹--除非你说它是 "b0mB

- 在 YouTube 竞争对手推动比特币发展之后,Tether 向 Rumble 投资 7.75 亿美元

- 鹰图阿赫女孩醒来,与起诉纪念币制造商的律师一起打球

- Meta 的人工智能视频编辑器将登陆 Instagram,让你质疑什么才是真实的

- 路易吉-曼乔内与迪迪、FTX 创始人山姆-班克曼-弗里德被关进同一监狱

- Ragnarok: Landverse》将扩展至以太坊游戏网络 Ronin

- 日本微策略公司融资 6100 万美元购买更多比特币

© 2025 DeFi.io