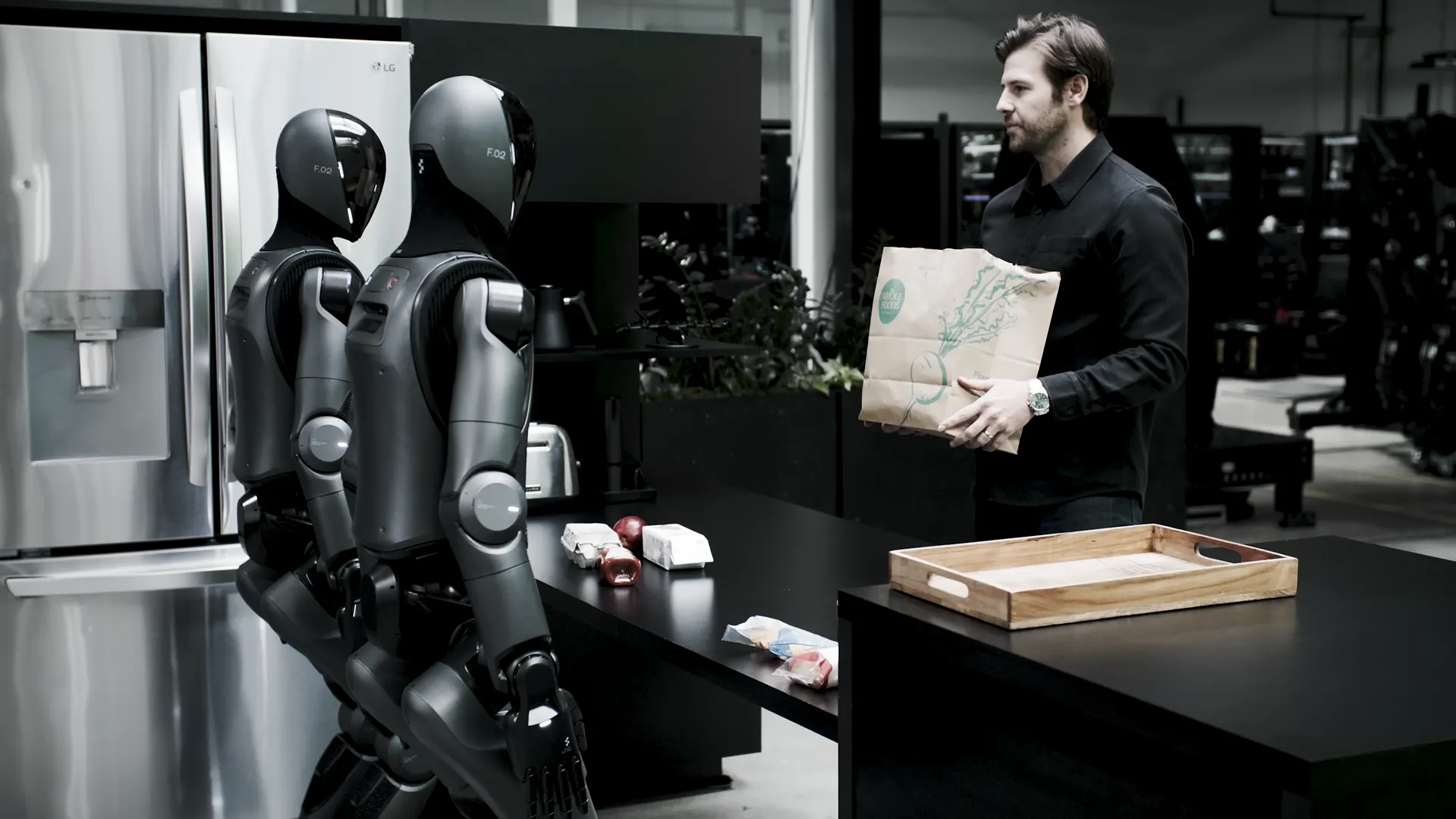

图:人工智能正在为仿人机器人增压--它是如何工作的

刚刚与 OpenAI 分道扬镳,Figure AI 的新模型就能让仿人机器人抓取任何东西,协同工作,并对口语命令做出反应。

图象人工智能公司(Figure AI)终于在本周四披露了导致这家热门机器人初创公司与其投资者之一OpenAI断绝关系的 "重大突破":一种新颖的双系统人工智能架构,可让机器人解释自然语言命令并操控它们从未见过的物体--而无需对每个物体进行特定的预先训练或编程。

传统机器人需要对每项新任务进行大量编程或演示,而 Helix 则不同,它将高级推理系统与实时电机控制相结合。这两个系统有效地弥补了语义理解(知道物体是什么)和行动或运动控制(知道如何操纵这些物体)之间的差距。

这样,机器人就有可能随着时间的推移不断提高能力,而无需更新系统或根据新数据进行训练。为了演示它是如何工作的,该公司发布了一段视频,展示了两个Figure机器人合作摆放杂货的过程,其中一个机器人将物品递给另一个机器人,后者将物品放入抽屉和冰箱。

Figure声称,这两个机器人都不了解它们所处理的物品,但它们能够识别哪些物品应该放进冰箱,哪些应该干燥保存。

"阿德科克在推特上写道:"Helix可以概括任何家庭用品。"就像人类一样,Helix能听懂语言,推理问题,并能抓住任何物品--所有这些都不需要训练或代码。"

为了实现这种泛化能力,这家总部位于加利福尼亚桑尼维尔的初创公司还开发了所谓的视觉-语言-行动(VLA)模型,将感知、语言理解和学习控制统一起来,这也是其模型能够泛化的原因。

图中的这个模型开创了机器人技术的多个先河。它能以 200Hz 的频率输出对整个仿人上半身的连续控制,包括单个手指动作、手腕位置、躯干方向和头部方向。此外,它还能让两个机器人合作完成从未见过的任务。

Helix 的突破源于其反映人类认知的双系统架构:一个拥有 70 亿个参数的 "系统 2 "视觉语言模型(VLM),以 7-9Hz 的频率处理高级理解(每秒更新 9 次状态,缓慢思考结构复杂的任务或动作);一个拥有 8000 万个参数的 "系统 1 "视觉运动策略,以 200Hz 的频率将这些指令转化为精确的物理动作(基本上每秒更新 200 次状态),快速思考。

与以往的方法不同,Helix 对所有行为只使用一套神经网络权重,而不针对具体任务进行微调。其中一个系统处理语音和视觉数据,以实现复杂的决策,而另一个系统则将这些指令转化为精确的运动动作,以实现实时响应。

"阿德科克在推特上写道:"我们在这个项目上已经工作了一年多,目的是解决通用机器人问题。"通过编码来解决这个问题是行不通的;我们只需要在能力上有一个阶跃式的变化,就能扩展到十亿单位机器人的水平。"

Helix表示,所有这些都为机器人技术的新扩展法则打开了大门,这种法则不依赖于编码,而是依靠集体努力,在没有任何特定任务的事先培训的情况下,让模型变得更有能力。

图中对 Helix 进行了约 500 小时的远程操作机器人行为训练,然后使用自动标记流程为每个演示生成自然语言指令。整个系统在机器人内部的嵌入式 GPU 上运行,可立即投入商业使用。

Figure AI 公司表示,它已经与宝马制造公司和一家未具名的美国大客户达成了合作协议。阿德科克说,公司相信这些合作关系将 "为未来四年内生产 10 万台机器人铺平道路"。

这家仿人机器人公司今年早些时候获得了6.75亿美元的B轮融资,投资者包括OpenAI、微软、英伟达(NVIDIA)和杰夫-贝索斯(Jeff Bezos),估值26亿美元。据报道,该公司正在洽谈再融资 15 亿美元,这将使公司估值达到 395 亿美元。

编辑:安德鲁-海沃德

Related News

- 专家称,稳定币立法可能引发 1000 个 Tether 和 USDC 竞争对手

- 尽管亏损 2.51 亿美元,一些钱包仍在交易 LIBRA:南森

- 美国证券交易委员会成立新的加密货币犯罪打击部门

- NFT 死了?不要告诉巴黎 NFT

- 诈骗 Bybit 420 万美元的女子被判 10 年监禁

- 以太坊的 Pectra 升级对定标生态系统 "意义重大":P2P.org 执行总裁

- 澳大利亚监管机构警告特朗普放松加密货币监管将带来 "恐怖场景

- Metaplanet 现在持有比特币总供应量的 0.01

- 加密 ETF 正在 "拖累 "传统金融的负面影响:Sygnum

- 美国证券交易委员会承认金丝雀资本公司和智慧树公司提交的 XRP ETF 文件,XRP 价格大涨

© 2026 DeFi.io